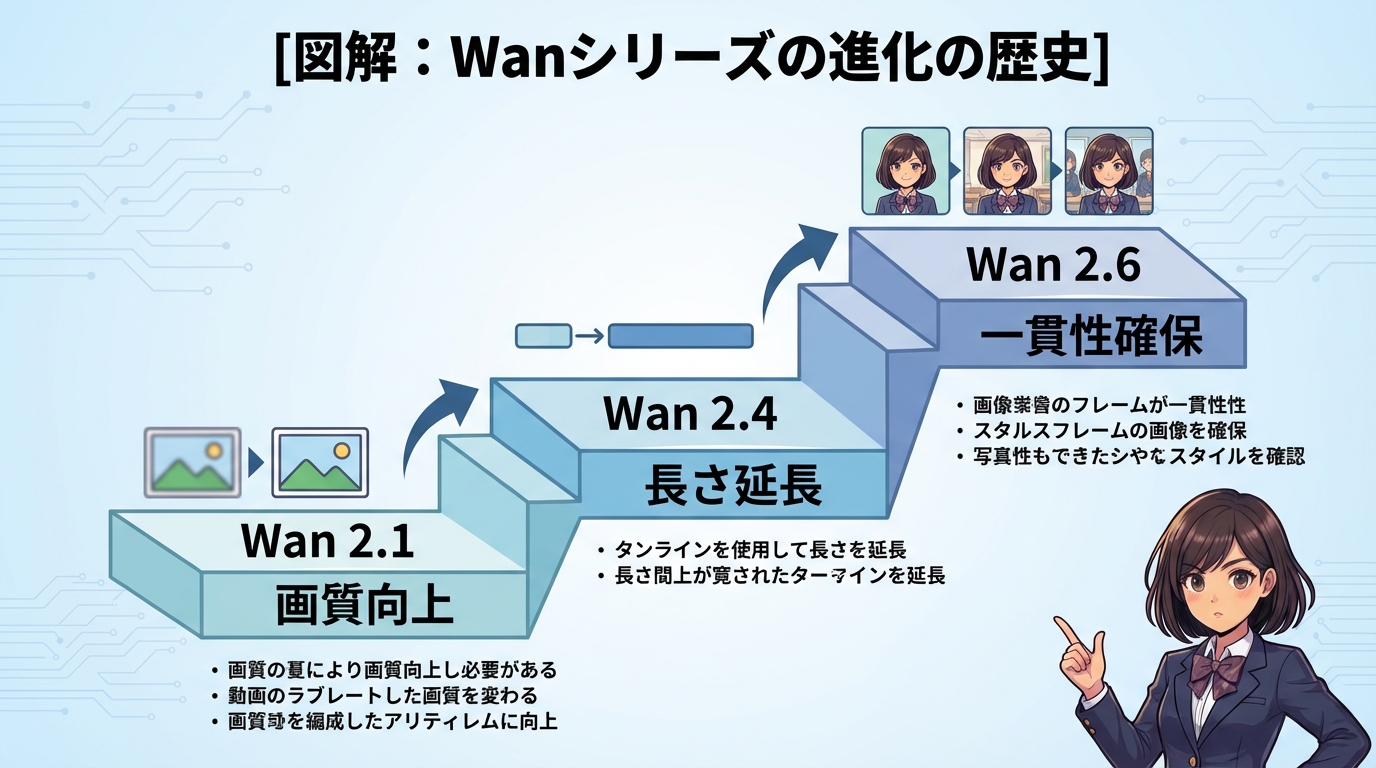

2026年現在、AI動画生成の技術はかつてないスピードで進化を遂げています。

その中心にいるのが、Alibaba(アリババ)が2025年12月17日に発表した最新モデル「Wan 2.6」です。

「動画生成AIを使ってみたけれど、キャラクターの顔が変わってしまう」

「10秒以上の長い動画を作ろうとすると破綻する」

「プロンプト(指示文)が複雑すぎて使いこなせない」

もしあなたがこのような悩みを抱えているなら、Wan 2.6はそのすべてを解決する鍵となるでしょう。

本記事では、前モデルWan 2.5から劇的な進化を遂げた「Wan 2.6」について、その特徴、使い方、そしてライバルであるSora 2との違いまで徹底解説します。

これを読めば、あなたは最新のAIトレンドを完全に把握し、クリエイティブな制作活動に革命を起こす準備が整います。

そもそも「Wan 2.6」とは何か?

結論:キャラクターの一貫性と物語性を両立させた「動画生成AIの完成形」

Wan 2.6とは、中国のテック大手Alibabaが開発した最新の動画生成AIモデルです。

これまでの動画生成AIは、「短いワンシーン」を作ることは得意でしたが、複数のカットをつなげて一つの物語を作ることや、同じキャラクターを別のシーンで登場させることが非常に苦手でした。

しかし、Wan 2.6はその壁を打ち破りました。

具体的には、「参照動画(Reference Video)」という機能を使うことで、キャラクターの顔や服装、雰囲気を維持したまま、新しい動きやシーンを生成することが可能になったのです。

なぜ今、Wan 2.6が注目されているのか?

2025年まで、動画生成AI界隈ではOpenAIの「Sora」やRunwayの「Gen-3」などが覇権を争っていました。

しかし、2026年に入り登場したWan 2.6は、以下の点で競合を圧倒しています。

- 一貫性の維持: 同一人物を別の動画で使い回せる

- 生成時間の延長: 最大15秒まで高品質な動画が作れる

- マルチショット対応: 複数のカメラアングルを一つの動画内で表現できる

これは単なる「バージョンアップ」ではありません。

クリエイターが「実験」ではなく「実務」で使えるレベルに到達した、歴史的な転換点なのです。

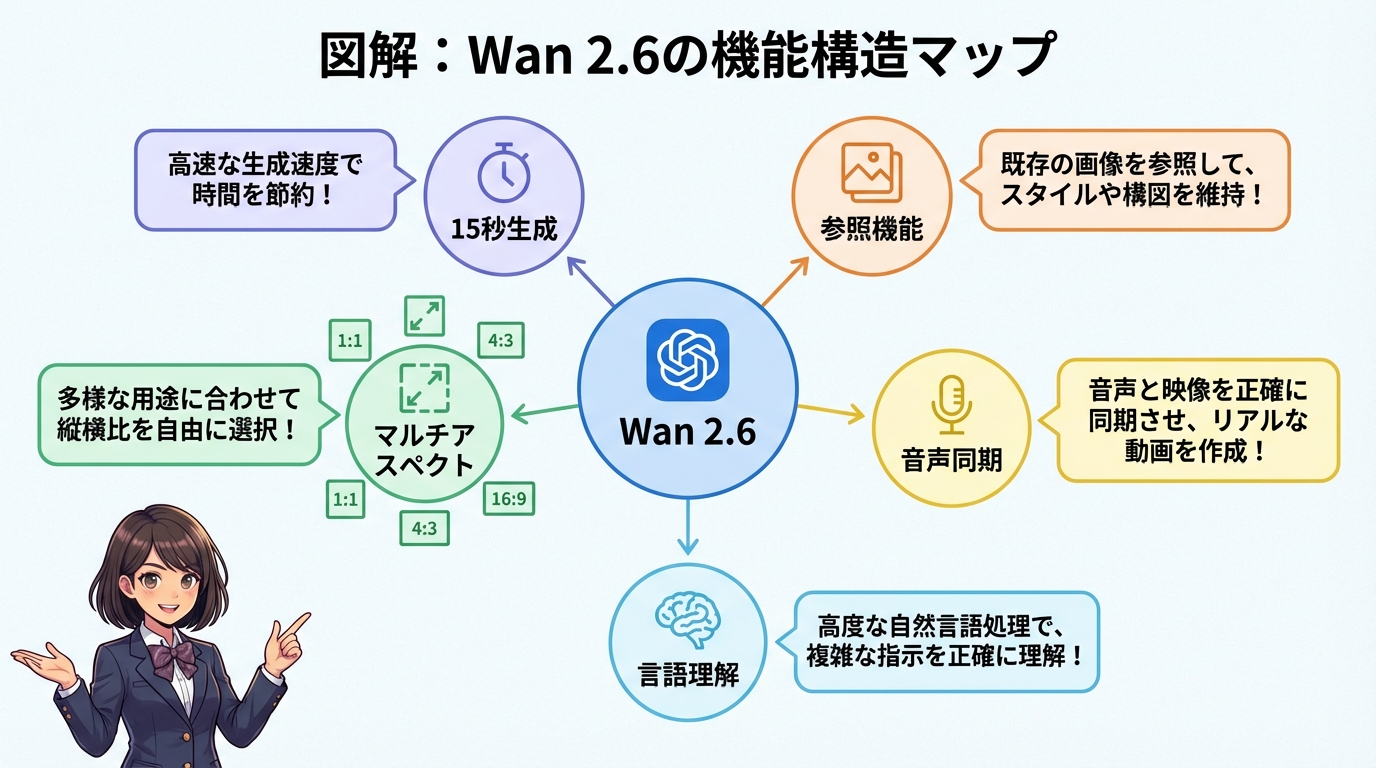

Wan 2.6がもたらす5つの革新的機能

ここでは、Wan 2.6が具体的にどのような機能を持っているのか、5つのポイントに絞って深掘りします。

1. 最大15秒の長尺生成とマルチショット機能

これまでの動画生成AI(Wan 2.5など)は、生成できる動画の長さが「最大10秒」という壁がありました。

「たった5秒伸びただけ?」と思われるかもしれません。

しかし、映像制作においてこの5秒は決定的な違いを生みます。

Wan 2.6では、最大15秒の動画生成が可能になりました。

さらに重要なのが、「マルチショット・ストーリーテリング」という機能です。

マルチショットとは?

通常のAI動画は、カメラが固定されたまま、あるいは一方向に動くだけの単調な映像になりがちです。

しかし、Wan 2.6は1つの動画の中で「カット割り」を理解します。

例えば、以下のような構成が1回の生成で可能です。

- 0〜5秒:主人公のアップ(クローズアップ)

- 5〜10秒:街全体を見渡す引きの画(ロングショット)

- 10〜15秒:主人公が走り出す後ろ姿(アクション)

これにより、あとで動画編集ソフトでつなぎ合わせる手間が激減し、AIだけで「物語」のある映像が作れるようになりました。

2. 「参照動画(Reference-to-Video)」によるキャラクター固定

これがWan 2.6の最大の目玉機能です。

従来のAIでは、プロンプトで「青い服を着た金髪の少年」と指定しても、シーンが変わるたびに顔つきや服のデザインが微妙に変わってしまいました。これは、映画やアニメを作りたいクリエイターにとって致命的な欠点でした。

Wan 2.6は、「Reference-to-Video(参照動画)」機能を搭載しています。

仕組みとメリット

ユーザーは、ベースとなる画像や動画をAIに「参照」として渡すことができます。

AIはその参照データから「このキャラクターはこういう顔で、こういう服を着ている」という特徴を厳密に学習し、新しい動画を生成します。

- 最大3つの参照元を同時利用可能: 顔、服装、背景など、複数の要素を別々の参照データから引っ張ってくることも可能です。

- 一貫性の維持: 走っても、振り返っても、横を向いても、キャラクターのアイデンティティが崩れません。

これは、企業の公式マスコットキャラクターを動かしたり、Vtuberのようなアバターを生成したりする際に絶大な威力を発揮します。

3. 多彩なアスペクト比と高解像度出力

SNS全盛の現代において、動画の「形(アスペクト比)」は非常に重要です。

Wan 2.6は、あらゆるプラットフォームに最適化されたアスペクト比に対応しています。

- 16:9: YouTube、テレビ、映画用

- 9:16: TikTok、Instagram Reels、YouTube Shorts用

- 1:1: Instagramフィード、Facebook用

- 4:3 / 3:4: レトロな表現や特定のタブレット向け

さらに、解像度は1080p(フルHD)に対応しており、フレームレートも24fps(映画と同じ滑らかさ)を実現しています。

生成された映像は「AIで作った粗い動画」ではなく、「そのまま映画館で流せるレベルの映像」に近づいています。

4. 音声との完璧な同期(オーディオインテグレーション)

「動画は綺麗だけど、音が合っていない」

これもこれまでのAI動画の課題でした。

Wan 2.6は、動画生成と同時に「音声生成」も行います。

しかも、単にBGMをつけるだけではありません。

- リップシンク(口パク): キャラクターが話す内容に合わせて、口の動きが自然に連動します。

- 効果音の同期: 足音、雨の音、ドアが閉まる音などが、映像のタイミングとぴったり合います。

15秒の長尺動画になっても、この音声同期の精度は落ちません。

これにより、ミュージックビデオやナレーション付きの解説動画の制作コストが大幅に下がります。

5. 高度なプロンプト理解力

Wan 2.6は、ユーザーが入力するテキスト(プロンプト)の理解力が飛躍的に向上しました。

以前は「呪文」と呼ばれるような、特殊で複雑な単語の羅列が必要でした。

しかし、Wan 2.6は自然言語処理(NLP)の能力が高まっているため、人間が話すような文章で指示を出しても、意図を正確に汲み取ってくれます。

「複雑なシーンの切り替え」や「抽象的な感情表現」も、以前よりはるかに高い精度で映像化してくれるため、プロンプトエンジニアリングの難易度が下がりました。

Wan 2.6 vs Sora 2 vs Wan 2.5 徹底比較

ここでは、競合モデルや前モデルとの違いを明確にするために、比較表を用いて解説します。

特に、最大のライバルである「Sora 2」との違いに注目してください。

スペック比較表

| 機能・項目 | Wan 2.6 (最新) | Wan 2.5 (前モデル) | Sora 2 (競合) |

|---|---|---|---|

| 最大生成時間 | 15秒 | 10秒 | 20秒〜 |

| 一貫性維持 | 非常に高い (参照機能あり) | 普通 | 高い |

| 解像度 | 1080p / 24fps | 720p〜1080p | 1080p〜4K |

| アスペクト比 | 16:9, 9:16, 1:1など全対応 | 限定的 | 全対応 |

| 音声生成 | ネイティブ対応 (同期高精度) | 対応 (同期甘め) | 対応 |

| 利用難易度 | 易しい (自然言語OK) | やや難しい | 普通 |

| 主な用途 | キャラクター動画、SNS、広告 | 短いクリップ | 映画、ドキュメンタリー |

Sora 2との決定的な違い

OpenAIのSora 2も非常に強力なモデルですが、Wan 2.6には明確な強みがあります。

それは、「キャラクター制御のしやすさ」です。

Sora 2は、風景や物理シミュレーション(水流や爆発など)のリアリティにおいて圧倒的ですが、特定のキャラクターを維持しながら物語を作る点においては、Wan 2.6の「参照動画機能」が一歩リードしています。

- Sora 2: 圧倒的な映像美、映画のような壮大なシーンが得意。

- Wan 2.6: キャラクター重視、SNS向けの展開、具体的な演出制御が得意。

あなたが「美しい風景動画」を作りたいならSora 2が、「特定の人物が登場するドラマ」を作りたいならWan 2.6が適しています。

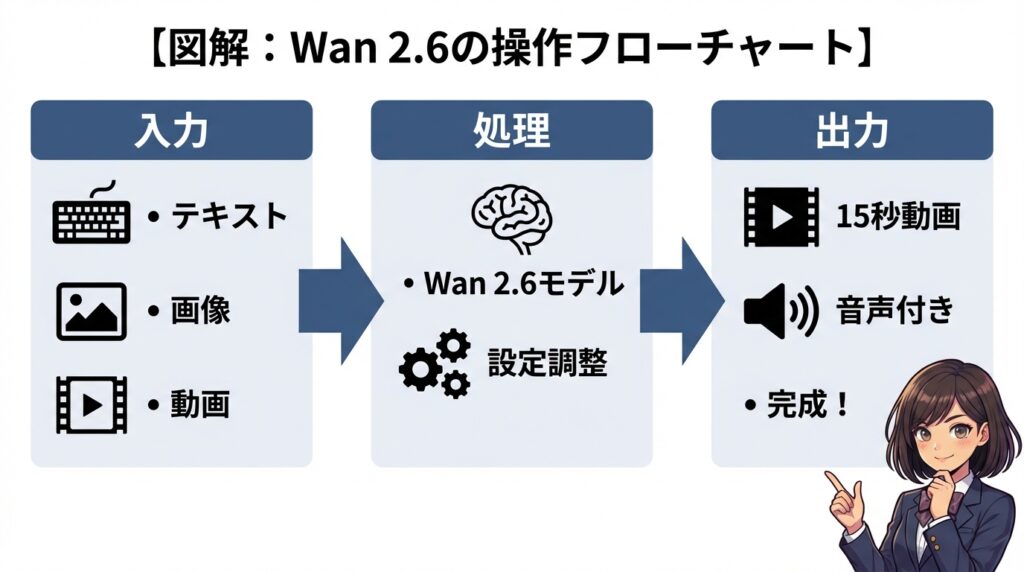

Wan 2.6の使い方:実践ガイド

では、実際にWan 2.6を使って動画を生成する手順を解説します。

現在は、WaveSpeedAIやHiggsfieldといったプラットフォーム、またはVEED などの動画編集ツール経由で利用するのが一般的です。

ステップ1:プラットフォームへのアクセス

まず、Wan 2.6のAPIを提供しているサービスに登録します。

ここでは、開発者やクリエイターに人気の「WaveSpeedAI」を例にします。

- WaveSpeedAIの公式サイトにアクセス。

- アカウントを作成し、APIキーを取得、またはWeb上の生成ツールを開く。

ステップ2:入力データの準備(マルチモーダル)

Wan 2.6は「マルチモーダル」対応です。つまり、入力素材として以下を使えます。

- テキスト: 生成したい内容を文字で指示。

- 画像: キャラクターの元絵や、背景画像。

- 動画: 動きの参考にしたい動画や、続きを作りたい動画。

キャラクターを固定したい場合は、ここで「参照画像」または「参照動画」をアップロードします。

ステップ3:プロンプトの作成

高品質な動画を作るためのプロンプトのコツを紹介します。

以下の4つの要素を盛り込むと、AIに意図が伝わりやすくなります。

- Subject(被写体): 誰が、何が映っているか(例:サイバーパンクな服を着た若い女性)

- Action(行動): 何をしているか(例:雨の中を走り抜け、振り返る)

- Camera(カメラワーク): どう撮るか(例:ドローンショット、クローズアップ、手ブレあり)

- Style(スタイル): どんな画風か(例:映画風、アニメ調、写実的、35mmフィルム)

プロンプト例(英語推奨ですが、日本語対応も進んでいます):

“A cinematic shot of a samurai standing in a neon-lit Tokyo street at night, heavy rain falling. The camera orbits around him (360 degree shot). High contrast, cyberpunk style, 1080p resolution.”

(夜のネオン輝く東京の街に佇む侍の映画的なショット。激しい雨。カメラは彼の周りを360度回る。高コントラスト、サイバーパンクスタイル、1080p解像度。)

ステップ4:設定と生成

- アスペクト比: 用途に合わせて選択(TikTokなら9:16)。

- デュレーション(長さ): 5秒、10秒、15秒から選択。

- 参照強度: 参照画像をどれくらい忠実に再現するかをスライダーで調整。

設定が完了したら「Generate」ボタンを押します。

クラウド上で処理が行われ、数分程度で動画が完成します。

具体的な活用事例:Wan 2.6で何が変わる?

技術的な話だけでなく、「実際にどう役立つのか?」という視点で、具体的な活用シーンを3つ紹介します。

ケース1:個人クリエイター・YouTuber

課題: 顔出しはしたくないが、オリジナリティのあるアバターで解説動画を作りたい。

解決: 自分の描いたイラストを「参照画像」としてWan 2.6に読み込ませます。テキストで台本を入力すれば、そのキャラクターが口を動かし、身振り手振りを交えて解説する動画が生成されます。これまでLive2Dなどで必要だった複雑な設定が不要になります。

ケース2:ECサイト・広告代理店

課題: 商品の宣伝動画を作りたいが、モデルの撮影やロケはお金がかかる。

解決: 商品の写真をWan 2.6に取り込みます。「海辺で商品を持っているモデル」というプロンプトで生成すれば、実際には行っていないロケーションでのCM映像が作れます。Wan 2.6の一貫性維持機能により、商品のロゴや形状が崩れることなく映像化できます。

ケース3:インディーズ映画制作

課題: 脚本はあるが、役者を雇う予算もCGを作る技術もない。

解決: Wan 2.6の「マルチショット」機能を活用します。シーンごとにプロンプトを入力し、一人のAI俳優(固定されたキャラクター)に演技をさせます。15秒のカットを複数生成し、つなぎ合わせることで、低予算で本格的なショートフィルムが制作可能です。

知っておくべき注意点と課題

Wan 2.6は素晴らしいツールですが、完璧ではありません。利用する上で知っておくべき課題もあります。

1. 生成コストと時間

高品質な動画(特に15秒の1080p)を生成するには、膨大な計算能力が必要です。そのため、APIの利用料金が高額になったり、サーバーが混雑していると生成に数十分待たされたりすることがあります。

2. 倫理的な問題とディープフェイク

「参照動画機能」は便利ですが、悪用されると実在の人物のフェイク動画(ディープフェイク)が簡単に作れてしまいます。

Alibabaやプラットフォーム側は、有名人の顔や不適切なコンテンツを生成できないように「セーフティチェッカー」を導入していますが、利用者のモラルも問われます。

3. 著作権の扱い

生成された動画の著作権が誰に帰属するかは、2026年現在も法整備が進んでいる途中です。商用利用する際は、利用するプラットフォーム(WaveSpeedAIなど)の規約を必ず確認してください。

まとめ:Wan 2.6は映像制作の「新しい標準」になる

ここまでWan 2.6の機能を見てきましたが、いかがでしたか?

「自分には難しそう」と感じた方もいるかもしれません。

しかし、思い出してみてください。Photoshopが登場したときも、スマホが登場したときも、最初は「難しそう」と言われていました。

Wan 2.6は、映像制作の民主化をさらに推し進めるツールです。

- もし、あなたの頭の中にある物語が、寝ている間に映像化されていたら?

- もし、たった一人でハリウッド映画のような予告編が作れたら?

それはもう「未来の話」ではなく、「今日できること」なのです。

最後に、本記事の要点をまとめます。

- Wan 2.6は「一貫性」と「物語」に強い: キャラクターを固定したまま、最大15秒の動画が作れる。

- 参照機能が革命的: 画像や動画を参照させることで、狙った通りのビジュアルを維持できる。

- あらゆる媒体に対応: アスペクト比の自由度が高く、SNSからYouTubeまで幅広く使える。

- Sora 2との違い: 風景や物理現象ならSora 2、キャラクターと演出ならWan 2.6。

- 今すぐ使える: WaveSpeedAIなどのAPIを通じて、誰でもアクセス可能。

動画生成AIの世界は、日進月歩です。

しかし、Wan 2.6が提示した「キャラクターの一貫性」と「マルチショット」という方向性は、今後のスタンダードになることは間違いありません。

まずは無料枠やトライアルを利用して、1本動画を作ってみてください。

そのクオリティの高さに、きっと驚くはずです。

新しい技術を恐れず、あなたのクリエイティビティを解放しましょう。

Wan 2.6は、そのための最強のパートナーです。